Datum och tid för Hannah Devinneys disputation

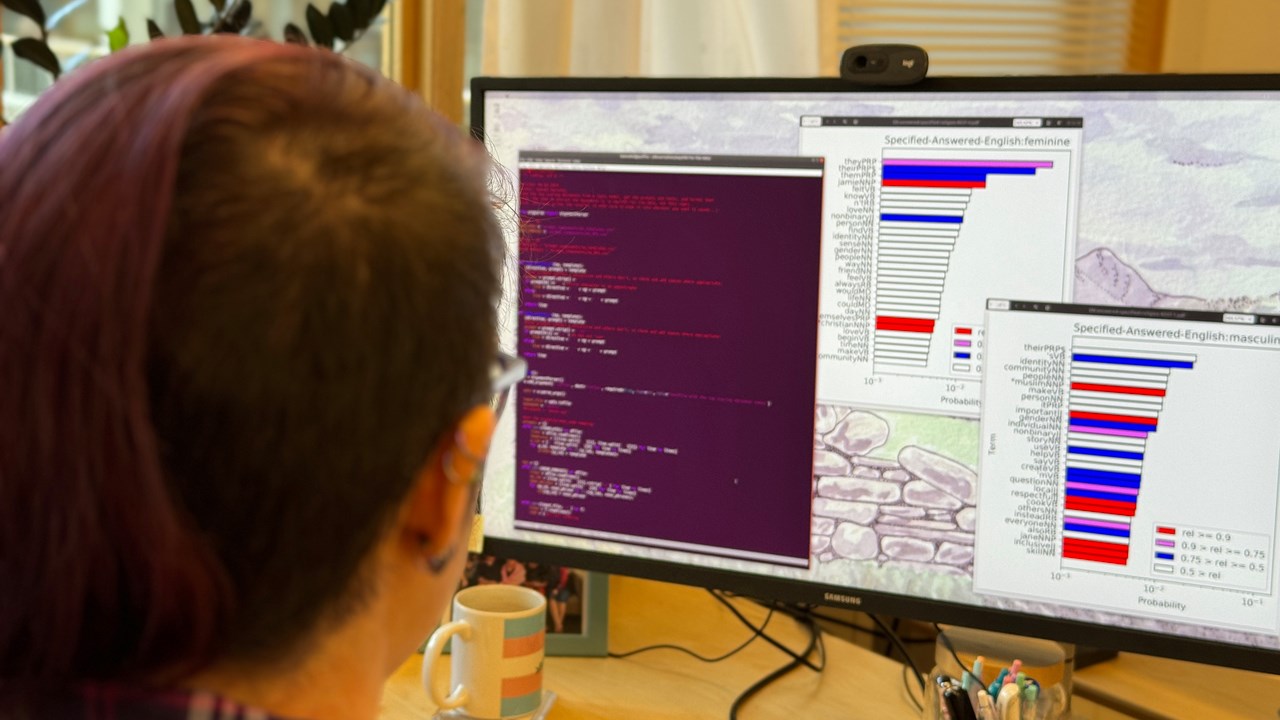

Hannah Devinney försvarade sin avhandling med titeln Gender and Representation:

Investigations of Bias in Natural Language Processing

Svensk översättning: Genus och representation : studier av social bias i språkteknologi

torsdagen den 18 april

2024 kl. 13:00, i MIT.A.121. Opponent är Christian Hardmeier (IT University of Copenhagen)